티스토리 뷰

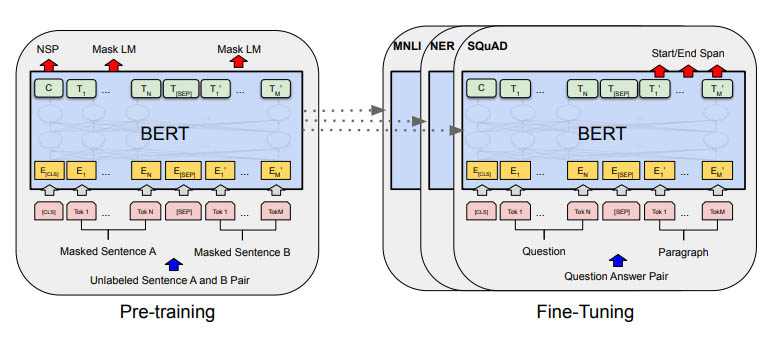

BERT (Bidirectional Encoder Representations from Transformers)는 2018년에 Google에서 개발한 언어 모델입니다. 이 모델은 대규모 텍스트 및 코드 데이터 세트로 학습된 트랜스포머(Transformer) 아키텍처를 기반으로 합니다.

트랜스포머는 인코더-디코더 구조를 가진 딥러닝 모델로, 기계 번역에서 뛰어난 성능을 보여준 모델입니다. 인코더는 입력값을 양방향으로 처리하는 반면, 디코더는 입력을 왼쪽에서 오른쪽으로 단방향으로 처리하는 것이 큰 차이점입니다.

구글은 BERT 논문을 통해서 GPT-1의 트랜스포머 디코드를 사용한 자연어 처리 능력은 문맥의 이해능력에 부족함이 있을 수 있으니, 이에 단순히 왼쪽에서 오른쪽으로 읽어나가는 디코더 보다 양방향으로 문맥을 이해할 수 있는 인코더를 활용한 랭귀지 모델을 BERT 라는 이름으로 발표를 합니다.

BERT는 양방향 인코딩 모델을 통해 텍스트 분류, 개체명 인식, 감정 분석과 같은 다양한 자연어 처리(NLP) 작업에 효과적인 것으로 나타났습니다.

또한 검색 엔진, 챗봇, 자동 번역과 같은 다양한 자연어 처리 애플리케이션에 사용되었습니다. 예를 들어, Google 검색은 BERT를 사용하여 검색 결과의 관련성을 개선하고, Google 챗봇은 BERT를 사용하여 보다 자연스러운 대화를 생성하고, Google 번역은 BERT를 사용하여 더 정확한 번역을 생성합니다.

BERT의 구조와 학습방식

인코더-디코더 아키텍처인 트랜스포머(Tansformer)를 기반의 인코더-디코더 모델입니다. 인코더는 입력 텍스트를 변환하고, 디코더는 변환값을 가져와 출력 텍스트를 생성합니다.

BERT의 인코더는 12개의 Transformer 블록으로 구성되고 디코더는 6개의 Transformer 블록으로 구성됩니다. 각 Transformer 블록은 Attention 메커니즘을 사용하여 입력 텍스트의 다른 부분에 액세스할 수 있습니다.

'BERT: 언어 이해를 위한 양방향 트랜스포머 사전 학습 논문 (참조)

BERT는 대규모 텍스트 및 코드 데이터 세트로 학습됩니다. 데이터 세트에는 책, 기사, 코드와 같은 텍스트가 포함되고, 데이터 세트에서 분류, 개체명 인식, 감정 분석과 같은 다양한 NLP 작업을 수행하는 방법을 학습합니다.

BERT의 사용

BERT는 검색 엔진, 챗봇, 자동 번역 등 다양한 NLP 애플리케이션에 사용되고 있습니다. Google 검색 결과의 관련성을 개선하고, 챗봇은 보다 자연스러운 대화를 생성하고, 번역기는 더 정확한 번역을 생성합니다.

BERT는 다양한 자연어 처리 작업에 효과적인 것으로 나타났으며 자연어 처리 분야를 발전시키는 데 도움이 되었습니다.

BERT의 미래

BERT는 아직 개발 중이며 앞으로 더 자연스럽고 정확한 NLP 애플리케이션을 개발하는 데 사용될 것입니다. 챗봇을 더 자연스러운 대화를 생성할 수 있도록 하고, 자동 번역을 더 정확하게 만들 수 있습니다. 새로운 질문 답변 시스템을 개발하거나 새로운 자연어 생성 시스템을 개발하는 데 사용될 수 있습니다.

'AI 이해' 카테고리의 다른 글

| 머신러닝 쉽게 이해하기 (0) | 2023.07.08 |

|---|---|

| 데이터셋(Datasets) - AI 학습을 위한 정보 (0) | 2023.07.06 |

| 자연어 처리의 트랜스포머(Transformer) 모델 (0) | 2023.07.05 |

| 신경 스타일 전송(NST) : 고흐가 그린 그림처럼 (0) | 2023.07.05 |

| 생성적 적대 신경망(GAN)의 이해 (0) | 2023.07.04 |